我们真正需要的AI,不是考试机器

过去几年,大语言模型的进步确实让人惊叹。

能解国际数学奥赛的题,能写复杂的代码,能通过各种专业考试。

但说句扎心的话:这些能力,并不是大多数人真正需要的。

你想想自己平时是怎么工作的。

一个程序员拿到一份新工具的文档,翻一翻就开始调 bug 了。一个玩家拿到新游戏的规则书,边看边学边玩。一个科学家对着一堆实验数据,从中发现新的规律。

这些场景有个共同点:我们不是在调用脑子里多年前学的知识,而是在当下、实时地从眼前的信息中学习。

这个能力,腾讯混元团队给它起了个名字,叫**「上下文学习」(Context Learning)**。

而他们的研究发现:当前最强的 AI,在这方面的表现,惨不忍睹。

什么是上下文学习?

先说清楚这个概念。

现在的大语言模型,核心能力来自预训练。简单说,就是在训练阶段把海量知识「压缩」进了模型参数里。推理的时候,模型主要靠「回忆」这些静态的内部记忆来回答问题。

这就产生了一个结构性的矛盾。

我们把模型优化成了「基于已知知识推理」的高手,但用户真正需要的,是模型能处理那些混乱的、不断变化的、全新的上下文信息。

举几个真实的例子:

- 给你一份 7 万字的无人机 SDK 文档,把自然语言的飞行指令转换成合规的代码

- 给你一本 1.5 万字的新游戏规则书,分析一个密室场景的所有可能结局

- 给你 300 条原始实验日志,推导出底层的物理关系,估算共振常数

这些任务,模型不能靠「已经知道的东西」来解决,必须从给定的上下文中现学现用。

这就是「上下文学习」的核心含义。

CL-bench:专门测这个能力的考卷

为了量化当前模型的上下文学习能力,腾讯混元团队做了一个 benchmark,叫 CL-bench。

规模不小:500 个复杂上下文,1899 个任务,31607 个验证标准。全部由经验丰富的领域专家手工标注,平均每个上下文花了 20 个小时。

核心设计原则只有一条:每个任务的解决,都必须依赖从上下文中学习新知识。

模型不能靠预训练时学到的东西来「蒙混过关」。

为了确保这一点,他们用了三种防污染策略:

第一,虚构创作。 专家直接编造全新的内容。比如给一个虚构国家设计一整套法律体系,包括判例和法律原则。或者发明一门全新的编程语言,有独特的语法和语义。

第二,修改现实内容。 在真实内容的基础上做变体。比如篡改历史事件、修改科学定义、改造技术文档。

第三,使用冷门和前沿内容。 那些在预训练数据中几乎没出现过的东西,比如最新的研究发现、刚发布的产品手册、极小众领域的专业知识。

效果如何呢?不给任何上下文的情况下,最强模型 GPT-5.1(High 模式)只能解决不到 1% 的任务。这说明数据确实是「干净」的。

四大测试维度

CL-bench 把上下文学习分成了四个类型:

领域知识推理。 给你一套特定领域的知识体系(比如一个虚构的法律系统、创新金融工具),你得用这些知识去推理和解决具体问题。

规则系统应用。 给你一套新定义的规则(比如新的游戏机制、数学形式、编程语法),你得理解这些规则并执行任务。

流程任务执行。 给你一套复杂的流程系统(比如工作流程、产品手册、操作指南),你得按流程完成任务。

经验发现与模拟。 给你实验数据、观察记录或模拟环境,你得从中发现规律和模式。这是最难的一类,因为它需要归纳推理,而不只是演绎推理。

其中 51.1% 的任务还有顺序依赖关系,也就是后面的题依赖前面的答案。这大幅增加了难度。

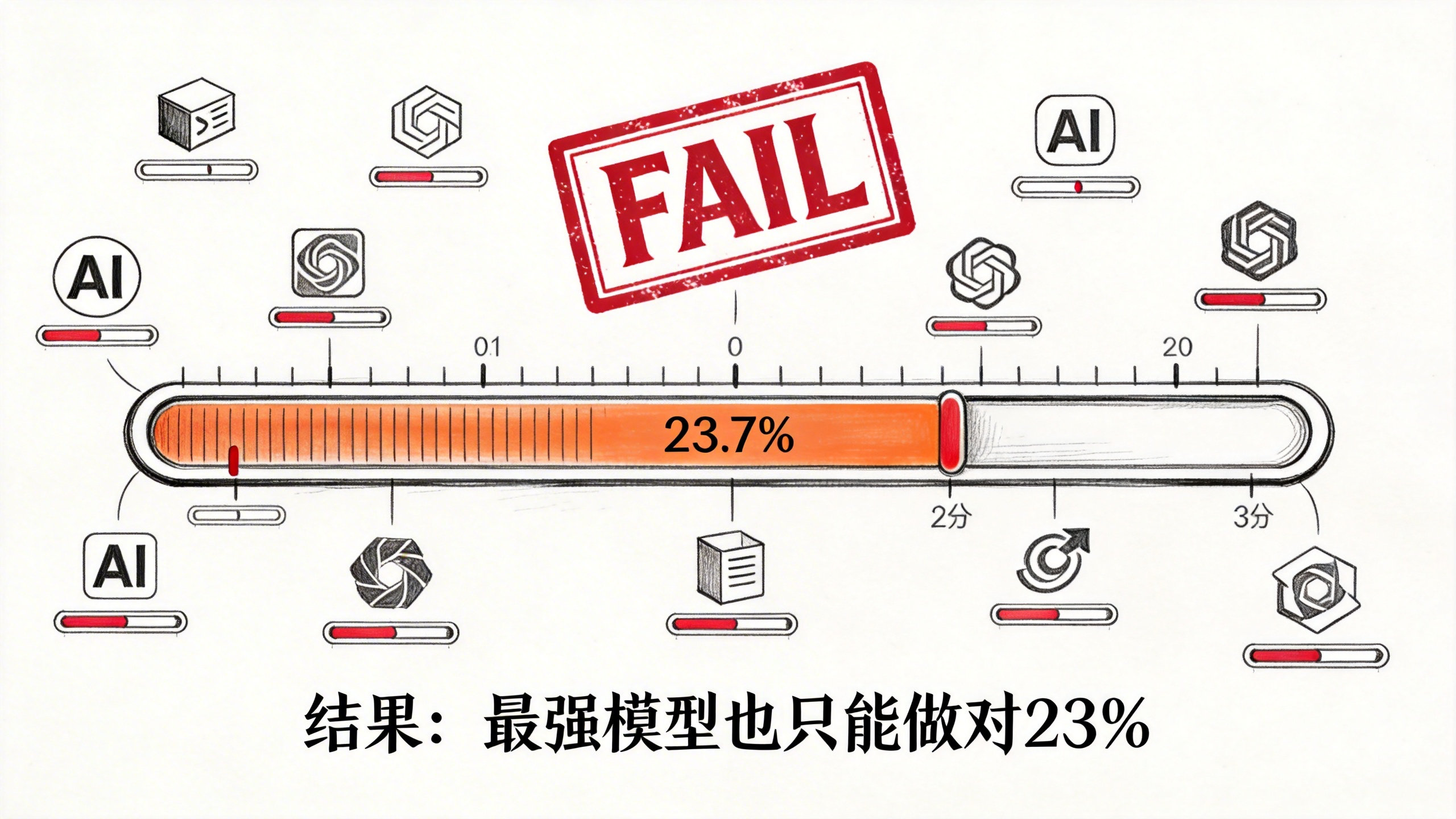

结果:最强模型也只能做对23%

腾讯团队测了 10 个最先进的大语言模型。

结果相当残酷。

平均下来,模型只能解决 17.2% 的任务。表现最好的 GPT-5.1(High 模式),也只做对了 23.7%。

换句话说,所有需要的信息都在上下文里摆着,模型就是学不会。

几个关键发现:

最大的失败原因:忽略或误用上下文。 很多错误不是因为信息不够,而是模型忽略了上下文中的关键细节,或者用错了。更有意思的是,模型经常会「退回」到预训练时学到的假设,即使上下文明确定义了新的规则和概念。

长上下文推理和指令遵循是必要条件,但不是充分条件。 即使模型能处理长文本、能遵循指令,还是会在上下文学习上翻车。这说明上下文学习是一种独立的能力,不只是这两项能力的叠加。

归纳推理比演绎推理难得多。 在需要从数据中发现规律的任务上,很多模型的成功率不到 10%,而且不同次运行的方差很大。相比之下,按照给定规则去演绎的任务就好做一些。

提高推理力度有一定帮助,但效果有限。 比如 GPT-5.1 在高推理模式下比低推理模式大约高 6%。但有些模型增加推理力度后反而变差了,说明光「想得多」没用,关键是模型能不能正确地吸收和组织上下文信息。

上下文越长越难,但短上下文也可能很复杂。 长度确实是瓶颈,但即使是短上下文,如果信息密度高、规则微妙、依赖关系复杂,同样会让模型栽跟头。

这意味着什么?

这个研究帮我们理解了一个常见的困惑:为什么在实际使用中,即使精心设计了 prompt 和上下文,模型还是经常在关键时刻掉链子?

答案是:提供上下文是不够的,如果模型根本学不会从中提取和运用信息。

上下文学习作为一项基础能力,长期以来被忽视了。在这个能力提升之前,大语言模型在最需要它们帮忙的场景(混乱的、动态的、真实世界的环境)中,依然会很脆弱。

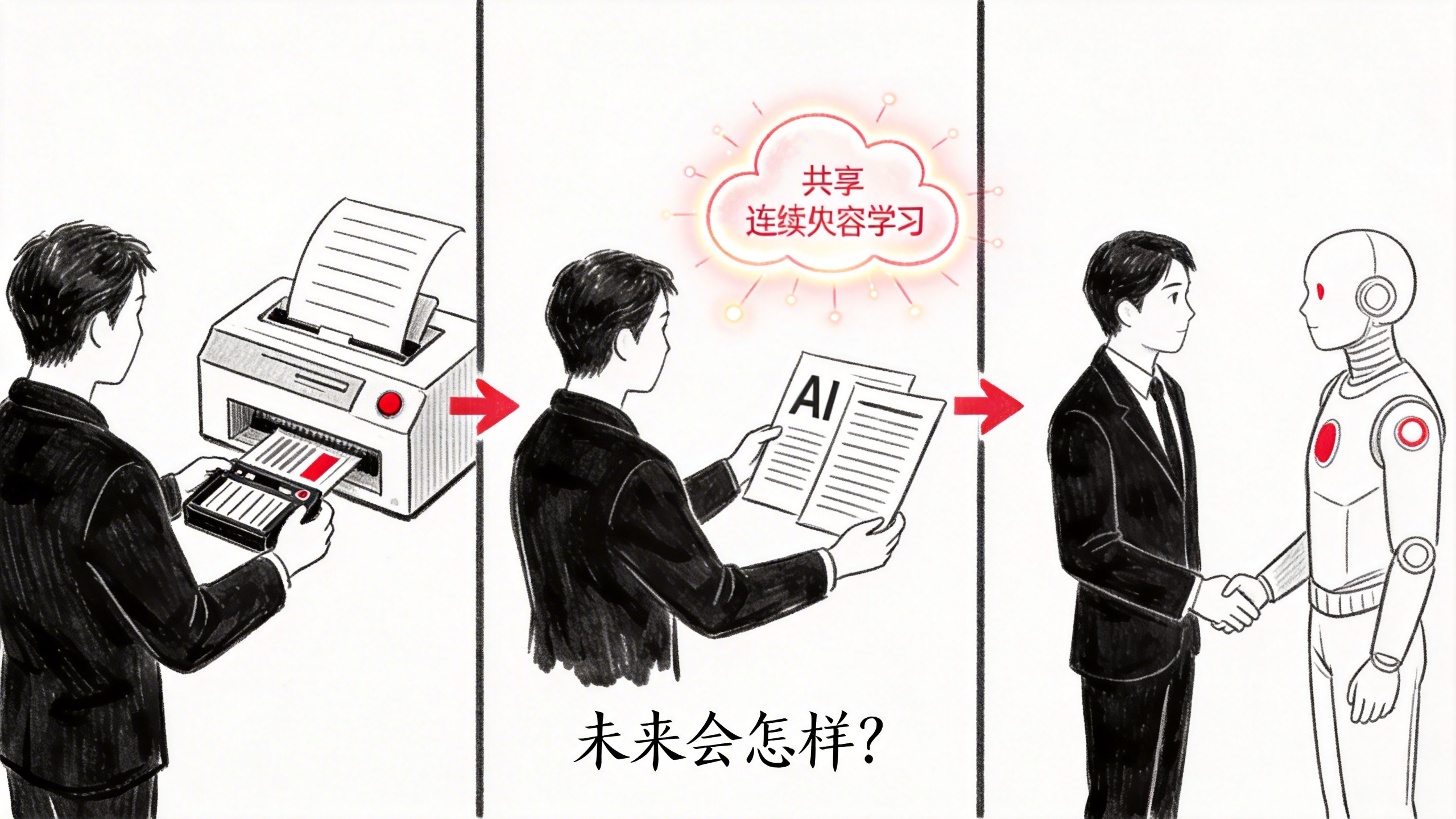

未来会怎样?

腾讯团队提出了一个有趣的展望。

如果上下文学习能力大幅提升,人和 AI 的关系会发生根本性的转变:人的角色会从训练数据提供者变成上下文提供者。

不再是「我给你喂数据让你学习」,而是「我给你提供当前场景的信息,你现学现用」。

但还有一个更深层的问题:上下文学习是短暂的。模型在当前窗口内学到的东西,窗口关了就忘了。

怎么让上下文中学到的知识变成持久的记忆? 这不只是记住事实,还包括技能、经验和模式。

这可能是下一个需要攻克的重大难题。

正如作者在文末写的:「是时候让上下文学习成为现实了。」