2月5号,OpenAI 和 Anthropic 同一天发布了各自的新模型,GPT-5.3-Codex 和 Claude Opus 4.6。

这事本身就挺有意思的。两家掐着同一天发,说明大家都知道对手要出牌了。

但更有意思的是,这次发布之后,整个AI圈的讨论方式变了。

没人再激动地转发跑分截图了。没人再说"XX模型全面碾压"了。大家讨论的都是:用起来到底怎么样?

这个转变,值得好好聊聊。

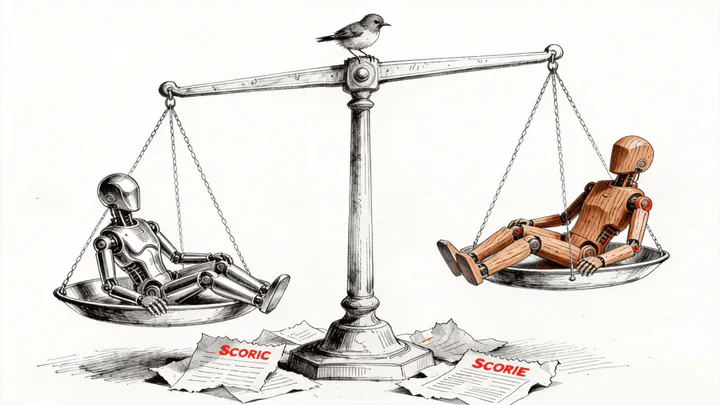

先说结论:Opus 更好用,Codex 更能打

Nathan Lambert(Interconnects AI 的作者,长期跟踪前沿模型的独立观察者)这几天两个模型都在高强度使用,他的体感是这样的:

Claude Opus 4.6 赢在"省心"。

你跟它说"清理一下这个分支,然后推个PR",它能理解上下文,把事情办妥。换成 Codex 5.3 做同样的事,你得像带新人一样,把每一步都交代清楚,不然它可能跳过文件,或者把东西放到奇怪的地方。

Codex 5.3 赢在"天花板"。

在复杂的代码理解和bug修复上,Codex 确实更强一点。Nathan 身边很多AI圈的朋友都对 Codex 赞不绝口,觉得它在高难度场景下就是能多走一步。

但这里有个关键问题:大多数人的日常使用,根本触碰不到那个天花板。

Codex 5.3 最大的变化:它终于不像"OpenAI的模型"了

这句话听起来像骂人,其实是夸。

之前的 Codex 版本,包括5.2,有个让人抓狂的问题,连创建一个新的 git 分支这种基础操作都经常搞砸。你能想象吗?一个编码助手,连最基本的版本管理都做不好。

Codex 5.3 最大的进步不是跑分提高了多少,而是它终于在"产品市场契合度"上追上来了。

Nathan 用了一个很精准的说法:Codex 5.3 feels much more Claude-like。反馈更快,任务覆盖面更广,从 git 操作到数据分析都能接住。

换句话说,OpenAI 终于意识到,光是模型能力强还不够,用户要的是"交给你一件事,你能靠谱地办完",不是"你在某个benchmark上多拿了两分"。

但两个模型都有同一个毛病

Nathan 提到一个很实际的问题:不管是 Opus 4.6 还是 Codex 5.3,当你一次给它们布置好几件事的时候,它们都会"选择性失聪",漏掉其中一些指令。

它们在处理范围明确、边界清晰的单个任务时表现最好。

这其实暗示了一个更深层的东西:当前的AI编码助手,本质上还是"执行者",不是"项目经理"。你不能把一堆事情甩给它然后去喝咖啡,你得像一个好的技术主管一样,把任务拆解好,一个一个喂给它。

会不会管理AI,正在变成一种新的核心能力。

真正重要的话题:跑分时代结束了

这才是这篇文章最值得关注的部分。

回想2023到2025年,每次新模型发布,大家第一件事就是看跑分。GPT-4 出来看跑分,Gemini 出来看跑分,o3 出来还是看跑分。那时候跑分确实有用,因为模型之间的差距大到肉眼可见,跑分高的模型用起来确实更好。

但现在不一样了。

Nathan 说他这次几乎没看评估分数。他注意到 Opus 4.6 的搜索得分高一点,Codex 5.3 每个回答用的token少一点,但这些数字完全无法告诉他"哪个模型更好用"。

为什么?因为模型之间的差异已经从"能不能做到"变成了"做得顺不顺手"。

这就像评价两个厨师,你不能光看谁切菜更快,你得看谁做出来的菜更好吃,谁的厨房更干净,谁更能理解你说"少放点盐"到底是什么意思。

Gemini 3 的教训:跑分之王,两个月就过气了

这个例子太经典了,值得单独拿出来说。

2025年11月,Google 发布 Gemini 3 Pro,整个行业都在欢呼"Google 回来了"。纽约时报的记者都在问"Google 是不是要重夺王座了?"

结果呢?两个月后,在编码智能体这个最关键的战场上,Gemini 几乎没有存在感。

跑分上的领先,没有转化成产品上的优势。用户在实际使用中选择了 Claude 和 Codex,Gemini 3 成了一个"假王者"。

这个故事告诉我们什么?在智能体时代,跑分领先和产品领先之间的关系,比我们想象的要弱得多。

Anthropic 做对了什么?

回头看,Anthropic 的战略眼光确实值得佩服。

2025年5月 Claude 4 发布的时候,Nathan 自己都承认他当时不太看好 Anthropic 押注编码的策略。那时候 OpenAI 和 Google 在比谁的模型能拿 IMO 金牌,谁的跑分更高,场面非常热闹。

Anthropic 选择了一条看起来不那么"炫"的路:专注做好智能体体验。

他们可能不是唯一看到智能体趋势的公司,但他们是第一个把整个公司的优先级调整过来的。不追跑分,不搞噱头,就是把"用起来顺手"这件事做到极致。

到了今天,Claude Code 成了编码智能体领域的标杆。如果要给一个没什么编程经验的人推荐AI编码工具,Nathan 说他毫不犹豫会推荐 Claude。

在智能体刚刚开始普及的窗口期,用户基数就是最大的护城河。 更多用户意味着更多使用数据,更多数据意味着更快的迭代,这是一个正向飞轮。

下一个战场:子智能体和"智能体团队"

文章最后提到了一个正在浮现的新方向:子智能体。

简单说,就是一个主智能体可以派出多个"分身",同时处理问题的不同部分,最后再把结果汇总。

评论区有个人做了个实验特别有意思:他让4个 Opus 4.6 智能体独立完成同一个任务,完全不协调,然后让第5个智能体综合结果。最终的综合输出比任何单个智能体的结果都好,而且4个智能体各自发展出了完全不同的解题思路。

这种"涌现行为"是任何跑分都测不出来的。

Claude 在子智能体功能上目前领先一点,但 OpenAI 有个独特优势:GPT-Pro 系列。当任务变得更复杂、更长期的时候,能在单个问题上调用更多算力,会成为关键的差异化因素。

所以,2026年我们该怎么选模型?

说实话,没有标准答案。

没有一个简单的表格能告诉你"做XX用这个模型,做YY用那个模型"。你需要同时使用多个模型,根据任务特点灵活切换,并且持续跟进每个模型的变化。

这听起来很麻烦,但换个角度想,这恰恰说明AI工具已经成熟到了一个新阶段。

就像你不会只用一把刀做所有的菜,你也不应该只依赖一个AI模型。真正的能力不是"选对模型",而是"知道什么时候用哪个模型,以及怎么用好它"。

评论区有个人说了一句我觉得特别到位的话:

一年之内,我们可能就不再比较"模型"了。真正有意义的比较会变成:模型 + 编排层 + 工具访问权限。模型本身的能力正在变成基本门槛。

我觉得他说得对。我们正在从"哪个模型更强"的时代,进入"谁的系统更好用"的时代。

这个转变,对每一个使用AI工具的人来说,都值得认真想想。